Openai Strawberry 200美金「中文就是Openai草莓」用Self-play RL克服Scaling Law困局时会不会威胁人类?

据科技媒体 The Information 最新报道, 两位测试过该模型的人士表示 OpenAI 计划在未来两周内发布 「草莓」(Openai Strawberry)新型推理人工智能模型,作为其 ChatGPT 服务的一部分,比此前预计的秋季时间要早。certainly,这个时间也不绝对准确,可能随时发生变化。今年3月曝光的一份文件显示,OpenAI计划在2027年以前,开发出人类水平的AGI。OpenAI 2022年就开始训练一个125万亿参数的多模态模型,该模型名为Arrakis或Q*,原本计划在2025年作为GPT-5发布,但因推理成本高而取消。OpenAI此后计划是2027年发布的Q 2025(GPT-8)将实现完全的AGI。而知名爆料人Jimmy Apples的说法是一个模型(可能被称为GPT-4.5)预计会在十月发布。同时,GPT-5很可能会在12月发布,但保险起见,说2025年第一或第二季度发布比较稳妥。

Strawberry, OpenAI’s reasoning-focused artifcial inteligence, is coming sooner thanwe thought.

Openai Strawberry(Openai草莓),OpenAI的以推理为中心的人工智能,来得比我们想象的要早。

科技界在热切期待着ChatGPT 的下一次迭代,各种OpenAI 新 AI 模型猜测也迅速网传出来。值得一提是虽然 「草莓」 主要作为 ChatGPT 的一部分发布,但本质上还是一个独立的产品。目前具体如何提供尚不清楚。「草莓」跟其他模型的最大区别是啥呢?答案是,更智能,但更慢、更贵。在定价方面,上周曾有消息称ChatGPT Plus当前付费价格是每月20美元,但OpenAI考虑将「草莓」和被外界誉为“ChatGPT 5”的「猎户座」(Orion)等全新大模型拟定在月付2000美元,等于定价提升100倍。有分析认为OpenAI能考虑如此高的价格跨度主要是因为缺钱、新产品足够强以及手握数亿用户。目前收费疑似200美元/月的定价,最大特色就是比其他模型多思考10到20秒。The Information还预测,目前为ChatGPT付费(每月20美元)的客户会比免费用户更早访问首个草莓模型。7

「Openai草莓」项目此前名为Q*,OpenAI的发言人在一份声明中表示:“我们希望自身AI 模型能够像我们(人类)一样看待和理解世界。持续研究新的AI能力是业界的常见做法,大家都相信这些系统的推理能力会随着时间的推移而提高。

克服Scaling Law困局

Openai草莓模型通过采用Self-play RL(自博弈强化学习)方法可在一定程度上克服Scaling Law(缩放定律)的困局。具体说明如下:

1、提升推理能力:Self-play RL让AI在自我对弈的过程中不断探索和学习,这种学习方式有助于AI理解问题的本质和推理过程而不仅是记忆数据,从而提升其推理能力。这对突破单纯依赖数据量和算力堆叠的Scaling Law困局具有重要意义。

2、高效利用数据:通过自博弈生成的数据质量高且丰富多样,可有助于AI在不需要大量外部数据的情况下提升性能,从而缓解“数据荒”问题。

3、优化模型性能:在自博弈过程中,AI会根据反馈不断优化策略,这种动态优化过程有助模型在推理任务上表现更好,而不仅依赖于静态的数据集和参数调整。

值得注意的是虽然Self-play RL为克服Scaling Law困局提供新的思路,但不意味它能完全替代传统Scaling Law方法。在实际应用中,两者可能会结合使用,以实现更好的性能提升和成本效益。

如今各家都走到同一路径——Self-play RL来打破瓶颈。Claude 3.5就是基于Self-play RL做出的,因此代码能力强到突出。而我们都知道草莓有一个重要作用是给下一代大模型合成数据,前提是它同样是基于新范式Self-play做出的。很多LLM的弱点就在推理能力上,而有些初创公司为提高它们的推理能力采用一种廉价技巧将问题分解为更小步骤,尽管这些方法速度慢且成本高昂。在草莓中,我们也看到类似思路。用Self-play RL去验证,自然就能让草莓的数学和代码能力上飞速暴涨。同样,付出的代价是极高的推理成本,导致它又贵、又慢。但得到的结果是极高的智能,或许启发我们通往AGI的路线就靠草莓这种思路。

说起「草莓之父」,其实是已离职的OpenAI的首席科学家Ilya Sutskever。在Ilya离职前,OpenAI的研究人员Jakub Pachocki和Szymon Sidor,在Ilya的工作基础上开发了一个新的数学求解模型Q*。据称Q*解决此前从未见过的数学题。Ilya做出使OpenAI不再受限获取足够高质量数据来训练新模型,正是开发下代模型的主要障碍。在去年Q*的前期准备中,OpenAI研究人员开发了一种被称为「测试时计算」的概念变体,目的是提升LLM的问题解决能力。so,LLM就会花更多时间考虑被要求执行的命令,或问题的各个部分。当时,Ilya发表一篇与这项工作相关的博客,展示出模型如何解决数个极有难度的数学问题。

谷歌DeepMind论文揭示「草莓」方法

我们还发现Menlo风投负责人、前谷歌搜索工程师Debarghya Das发推:Google DeepMind在最近一篇论文中提出的方法,可能就是OpenAI在Strawberry上用的。

Openai Strawberry 200美金「Openai草莓」用Self-play RL克服Scaling Law困局时会不会威胁人类?

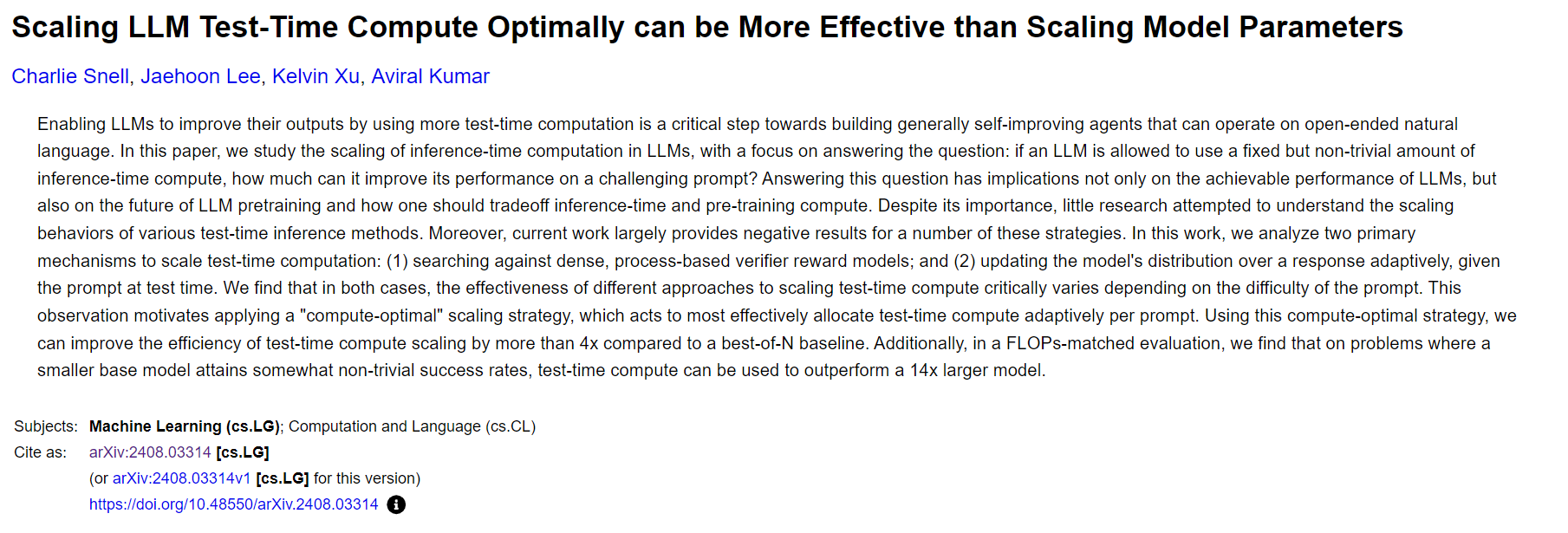

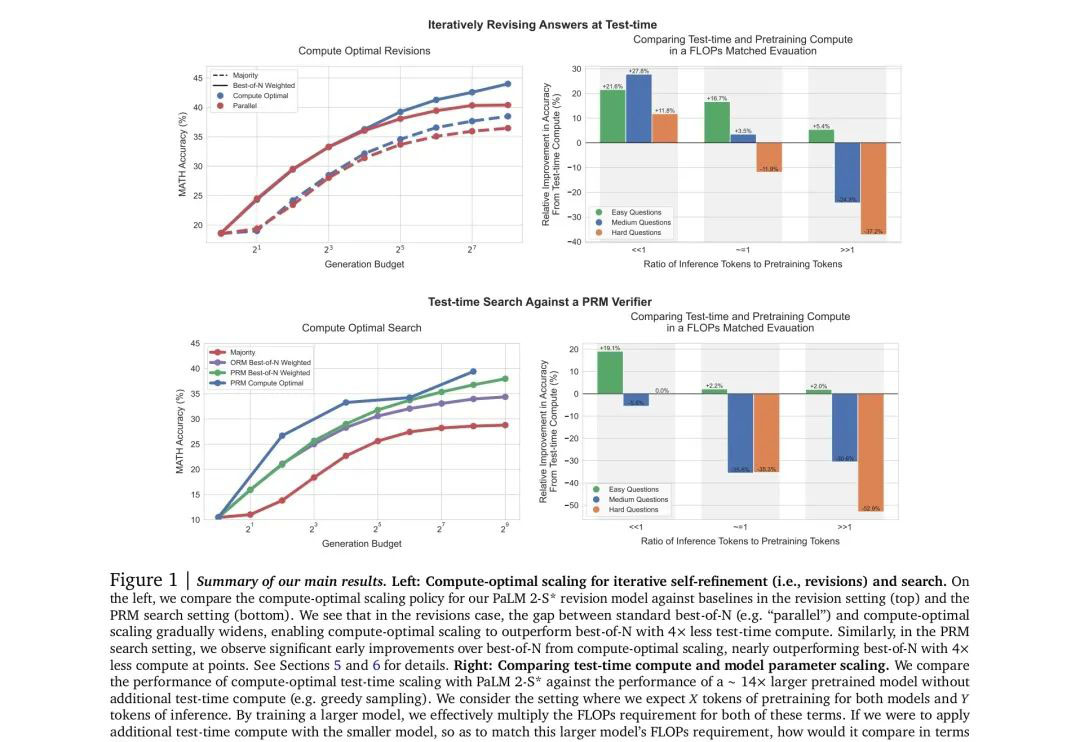

论文提出让LLM进行更多「测试时计算」(test-time computation),对构建能在开放语境下操作、能实现自我提升的agent是关键一步。这篇论文重点研究扩展「推理期计算」(inference-time computation)这个问题。如果允许LLM使用固定但非平凡量的推理期计算,它在应对具有挑战性的提示词时,可以有多少性能提升?这个问题不仅影响LLM的可实现性能,还关系LLM预训练未来及如何在推理计算和预训练计算之间进行权衡。研究团队为此分析扩展测试时计算的两种主要机制:

- 针对密集的、基于过程的验证器奖励模型进行搜索;(2)根据测试时得到的提示词,自适应更新模型对响应的分布。

结果显示以上两种情况对测试时计算的不同扩展方法的有效性,在很大程度上取决于提示词的难度。

Openai Strawberry 200美金「Openai草莓」用Self-play RL克服Scaling Law困局时会不会威胁人类?

论文地址:https://arxiv.org/abs/2408.03314

研究团队基于此提出一种「计算最优」扩展策略——通过为每个提示词自适应地分配测试时计算,使测试时计算的扩展效率提高4倍以上。另外,在FLOPs一致的评估中,对于那些较小的基础模型已取得一定程度非平凡成功率的问题,测试时计算可以使其超越规模大14倍的模型。

Openai Strawberry 200美金「Openai草莓」用Self-play RL克服Scaling Law困局时会不会威胁人类?

Openai Strawberry 200美金「Openai草莓」用Self-play RL克服Scaling Law困局时会不会威胁人类?

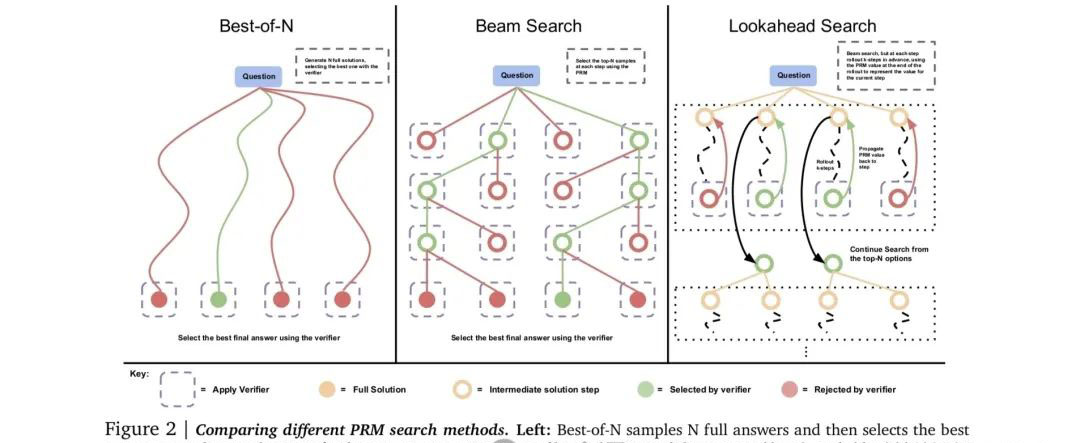

但网友们对这一猜测并不认可。Topology首席执行官Aidan McLaughlin表示谷歌DeepMind探讨的是最佳N采样和蒙特卡洛树搜索(MCTS)。而「草莓」可能会是一个具有特殊token(回溯、规划等)的深度混合模型。它可能会通过人类数据标注者和来自易于验证领域(如数学/编程)的强化学习进行训练。

Openai Strawberry 200美金「Openai草莓」用Self-play RL克服Scaling Law困局时会不会威胁人类?

我们还发现有另一位网友提出:“「草莓」不是一个神经符号模型吗?”

Openai Strawberry 200美金「Openai草莓」用Self-play RL克服Scaling Law困局时会不会威胁人类?

Deedy对此的解释是根据网上信息和传闻,『草莓』将通过在响应空间中使用搜索技术改进推理,其推理时间计算为10到20秒,这正是这项研究所解释的内容。

Openai Strawberry 200美金「Openai草莓」用Self-play RL克服Scaling Law困局时会不会威胁人类?

「草莓」会威胁人类?

2023年11月,媒体称OpenAI代号Q*的项目实现重大突破,让人类实现通用人工智能(AGI)的步伐大大提速,但OpenAI CEO 奥特曼可能没有和董事会详细披露Q*的进展。OpenAI的内部人士向董事会致信警告Q*的重大发现可能威胁全人类。人工智能(AI)研究者早就在争论用什么标准判断人类实现了通用人工智能(AGI)。OpenAI最近开发一套系统“自定义”AI进化等级,以此追踪开发人类级别AI的进展。美东时间7月11日,OpenAI的发言人称,OpenAI在7月9日的公司全体会议上与员工分享了新的分类系统,计划与投资者和公司外部人士分享这些等级的信息。OpenAI的系统划分五个AI水平,按一到五的数字由低到高排列等级。OpenAI的高管告诉员工,公司认为目前自身产品处于第一级,但即将达到第二级,也就是,可以完成基本问题解决任务的系统,类似于拥有博士学位但无法使用任何工具的人。7月11日OpenAI的发言人表示,OpenAI一直在内部测试新功能,这是业内的常见做法。对于OpenAI开发AI分级系统的消息,有网友表示,担心AI超越人类可能带来的风险,不知道那对经济和就业有何影响?

目前并没有草莓模型会威胁人类的确切证据,任何其他类型的模型、算法和人工智能技术都是人类为了解决特定问题而创造的工具。However,这些技术的应用方式和目的,以及我们如何管理和控制它们,可能会对人类产生积极或消极的影响。以下是一些关于AI和模型(如草莓模型)可能对人类产生影响的方面:

1. 就业影响:自动化和AI可能会导致某些工作岗位消失,尤其是那些重复性、低技能的工作。这可能会导致失业和经济不平等问题。

2. 隐私和安全:AI和数据分析可能会侵犯个人隐私,尤其是当数据被不当使用或遭到黑客攻击时。

3. 决策偏见:如果AI模型在训练时使用有偏见的数据,那么它的决策也可能带有偏见,这可能会导致不公平和歧视。

4. 道德和伦理问题:在某些情况下,AI的决策可能会涉及生命和死亡的问题,例如在自动驾驶汽车中。我们该如何确保AI在这种情况下做出正确的决策?

5. 超级智能风险:虽然目前还远未实现,但有些专家担心如果未来出现比人类更聪明的AI,它可能会追求与人类利益不一致的目标。

6. 依赖性增加:随着对AI的依赖增加,我们可能会失去某些技能,例如导航能力,因为我们过于依赖GPS。

「草莓」模型或其他任何AI技术,其本身并不是威胁。真正的威胁来自于我们如何使用、管理和控制这些技术。为确保AI的正面影响并减少潜在负面影响,我们需要制定明智的政策、法规和伦理准则,并持续进行公众教育。「草莓」模型通过引入Self-play RL的方法,有望在一定程度上克服Scaling Law的困局,推动AI技术的发展。

.webp)

No comments yet